Utiliser l’intelligence artificielle pour créer un radar à ouverture

Oculli a développé un radar avec la résolution de remplacer le lidar dans les systèmes d’aide à la conduite.

Les constructeurs automobiles cherchent à équilibrer les coûts et les capacités en augmentant les capacités avancées d’assistance à la conduite de leurs voitures. Tesla, de manière quelque peu controversée, a récemment abandonné l’utilisation du radar sur ses véhicules en faveur d’un système de capteurs uniquement avec caméras. Oculli fournit un logiciel d’IA pour la perception radar, nous avons donc pensé que ce serait une bonne idée de parler au PDG et co-fondateur Steven Hong de ses réflexions sur les compromis entre les systèmes de caméra, de radar et de lidar et comment le radar intelligent peut aider à remplir dans les écarts entre leurs différentes capacités.

Design News : Quels sont les avantages et les inconvénients des capteurs radar par rapport aux caméras et au lidar pour les systèmes avancés d’aide à la conduite (ADAS) ?

Steven Hong : Le radar est une technologie durable, rentable et éprouvée sur le marché qui existe depuis le 19e siècle. Il maintient sa précision dans de mauvaises conditions météorologiques et a des besoins en énergie beaucoup plus faibles que les autres capteurs. La raison pour laquelle le radar n’a pas été largement utilisé dans la perception des véhicules autonomes jusqu’à présent est qu’il avait une mauvaise résolution spatiale, une sensibilité limitée et un champ de vision étroit.

Mais les capteurs radar les plus récents, en particulier ceux que nous avons construits à Oculii, sont équipés d’un logiciel d’IA qui leur permet d’apprendre de leur environnement, améliorant considérablement tous ces facteurs, jusqu’à 100 fois. Malgré les meilleures performances, le coût de ces capteurs radar améliorés est presque égal à celui des options radar existantes, donc pour les constructeurs automobiles ADAS, il n’y a pratiquement aucune interruption du processus de fabrication.

Le lidar et la caméra ont tous deux été traditionnellement meilleurs pour détecter les objets immobiles ou éloignés. Les caméras en particulier sont douées pour voir le monde tout comme les yeux humains sont conçus pour, ce qui peut être utile pour déterminer les mots sur un panneau ou la couleur d’un feu de circulation.

Ils sont également moins chers que le lidar, ce qui est l’une des raisons pour lesquelles Tesla les envisage. Leur inconvénient est que, tout comme les yeux humains, les caméras peuvent être trompées par les ombres, la lumière du soleil ou les phares venant en sens inverse d’autres voitures. De plus, ils ont du mal à fonctionner si la lentille se salit ou est obstruée par la pluie ou le brouillard.

Historiquement, le lidar a eu la meilleure précision des trois outils. Il peut percevoir des visuels complexes tels que la direction et la vitesse des cyclistes, et même prédire leur mouvement. C’est pourquoi de nombreux fabricants de véhicules autonomes haut de gamme l’utilisent. Mais pour un système ADAS, ce niveau de précision n’est pas seulement excessif, mais son coût est prohibitif.

Les systèmes ADAS sont produits pour les marchés de masse, et un véhicule lidar peut coûter jusqu’à 70 000 $, sans parler des coûts supplémentaires associés au stockage et à la puissance de calcul. Ce sont des ordres de grandeur de coût qui sont tout simplement irréalistes pour le fabricant moyen de véhicules ADAS grand public.

DN : Qu’est-ce qu’un radar d’imagerie à ouverture et comment Oculii AI en crée-t-il une version virtuelle ?

Steven Hong : Le radar d’imagerie à ouverture est une forme de radar utilisée pour créer des images bidimensionnelles ou des reconstructions tridimensionnelles d’objets. En règle générale, la reconstruction est réalisée en utilisant un réseau d’antennes pour capter les ondes radar. L’onde radar rebondit sur les objets et l’antenne capte ces changements de longueur d’onde pour créer un paysage visuel de base.

Plus vous avez d’antennes pour collecter ces informations, plus l’image devient claire. C’est un moyen très économique de naviguer, surtout par rapport aux lidars ou aux caméras. Le seul problème est que pour obtenir le type de clarté et de résolution d’image dont vous auriez besoin pour conduire en toute sécurité un véhicule autonome, vous auriez besoin d’au moins 200 antennes, et certains des derniers systèmes radar actuellement disponibles en ont en fait autant. . Mais chacune de ces antennes va augmenter le coût, la taille, la complexité et la consommation d’énergie.

Ce qui est intéressant avec un radar d’imagerie à ouverture virtuelle, comme celui que nous avons construit chez Oculii, c’est que vous pouvez utiliser un logiciel pour augmenter les performances de quelques antennes seulement pour atteindre une résolution que vous n’obtiendriez généralement qu’avec des centaines. Dans notre cas, nous utilisons environ douze antennes par véhicule, mais comme ce logiciel améliore les performances de chacun de ces capteurs et crée une image de conglomérat plus intelligente, il s’agit essentiellement de la même clarté d’image qu’un système avec 200 antennes.

Mieux encore, la plate-forme logicielle d’Oculii évolue constamment en exploitant des modèles de données radar uniques et propriétaires. Cela signifie que les futures générations de capteurs construits avec le logiciel Oculii AI évolueront de manière exponentielle, offrant une résolution nettement plus élevée et une portée plus longue dans un boîtier moins cher et plus compact.

Unités radar Oculii’s Eagle (à gauche) et Falcon (à droite).

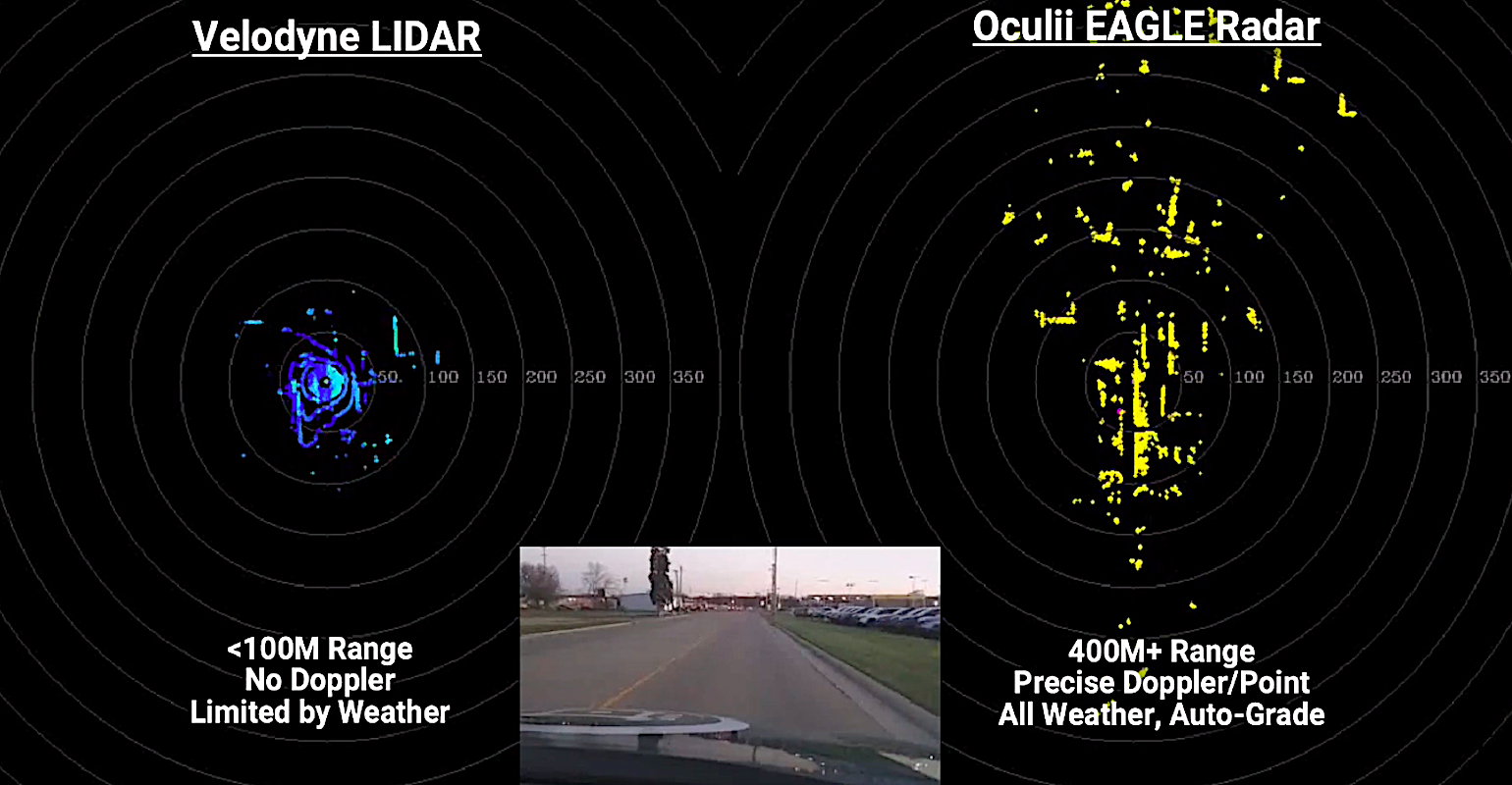

DN : Quelles sont les performances du radar d’imagerie à ouverture virtuelle Oculii ?

Steven Hong : Oculii propose deux produits qui déploient son radar d’imagerie à ouverture virtuelle, EAGLE et FALCON.

EAGLE est le radar d’imagerie 4D commercial à la plus haute résolution de l’industrie. Il peut fournir une résolution spatiale conjointe de 0,5 degré horizontal par 1 degré vertical sur un large champ de vision instantané horizontal de 120 degrés par 30 degrés vertical. Générant des images radar avec des dizaines de milliers de pixels par image, EAGLE suit les cibles à plus de 350 mètres, permettant au radar de fonctionner dans n’importe quel type de temps, y compris la pluie, la neige ou le brouillard.

Il est également capable de suivre avec précision des cibles que le radar a du mal à percevoir, comme les piétons et les motocyclistes dans des environnements surpeuplés. Cela signifie qu’un véhicule autonome utilisant EAGLE n’aura aucun problème à naviguer dans les rues animées de la ville. De plus, EAGLE offre la résolution spatiale d’un radar en cascade à 8 puces (24T32R) sur une plate-forme matérielle à 2 puces (6T8R) économique et à faible consommation. Cela signifie qu’EAGLE consomme moins de 5 W de puissance totale sur un capteur plus petit qu’une fiche.

Encore plus petit que cela, FALCON est le radar d’imagerie 4D le plus compact de l’industrie, offrant des performances haute résolution dans un boîtier de 5 cm x 5 cm plus petit qu’une carte de visite. Offrant une résolution horizontale de 2 degrés sur un large champ de vision de 120 degrés, FALCON peut également mesurer simultanément l’élévation des cibles. Avec quatre capteurs FALCON fusionnés, les véhicules autonomes sont dotés d’une bulle de sécurité à 360 degrés jusqu’à 200 mètres dans toutes les directions, efficace dans toutes les conditions environnementales.

Construit sur une plate-forme matérielle monopuce (3T4R), basse consommation et économique, FALCON consomme moins de 2,5 W, ce qui le rend parfait pour les applications ADAS automobiles de radar de coin ou une application robotique autonome où l’efficacité énergétique est critique.

DN : Quelles sont les économies de coûts potentielles de la substitution du lidar ?

Steven Hong : Il est tentant de simplement regarder les coûts matériels du lidar par rapport au radar, qui, lorsque vous les analysez, peuvent représenter une différence de plusieurs milliers de dollars. C’est déjà important, mais ce qui est encore plus important en termes d’économies de coûts, c’est ce qui alimente ces deux outils.

|

Oculii

Le PDG et co-fondateur d’Oculii, Steven Hong. |

D’une part, les capteurs radar d’Oculii sont des systèmes à faible consommation d’énergie et à faible calcul qui sollicitent très peu les besoins globaux d’énergie et de stockage de données d’un véhicule. D’un autre côté, le fonctionnement du lidar signifie qu’il impose une énorme demande sur la consommation d’énergie et le stockage de données d’une unité autonome.

Le lidar est beaucoup moins efficace que le radar car il génère des millions de points de données par seconde. Cela peut sembler génial, mais cela signifie en fait que le système informatique d’un véhicule autonome doit travailler extrêmement dur pour stocker tous ces points de données, trier ceux qui comptent et ceux qui ne le sont pas, puis interpréter ce que signifient réellement ces informations et Que dois-je faire avec ça. Tout ce stockage et ce calcul sont extrêmement gourmands en énergie, délicats et coûteux.

Le matériel est donc supérieur d’un ordre de grandeur en termes de dépenses. Mais le stockage de données en est une autre, et le calcul et le traitement en sont une autre. Le prix de base d’un système lidar, qui est déjà assez élevé, devient exponentiellement plus cher lorsque l’on prend en compte ces composants supplémentaires.

DN : Tesla a abandonné le radar de ses voitures au profit d’un système à caméra uniquement. Qu’est-ce qui est perdu en termes de sécurité et de fiabilité si d’autres capteurs sont éliminés, car différents capteurs ont des vulnérabilités différentes et plusieurs systèmes assurent la redondance ?

Steven Hong : Ce que Tesla fait avec son système de caméra, c’est effectivement inférer la structure. Si un humain regardait à l’horizon et voyait trois voitures rouler sur la route, par exemple, il ne pourrait pas affirmer avec confiance que la voiture A est à 16,3 mètres et que la voiture B est à 85,2 mètres et que cette voiture est à 100,7 mètres. Vous pouvez avoir une idée de leurs distances relatives, mais il n’y a aucun moyen de le dire avec certitude.

C’est aussi ce que fait le système de caméra de Tesla. Il peut approximer la distance, mais il ne peut pas savoir avec certitude. Et cela peut convenir pour les types d’applications à faible vitesse, mais cette imprécision à des vitesses plus élevées et à des portées plus longues pourrait entraîner de gros problèmes.

Le radar, et en fait le lidar, interrogent directement l’environnement et mesurent directement sa structure 3D. Même si une caméra est excellente pour deviner et est précise à 99%, le radar et le lidar fournissent tous deux une mesure directe en tant que vérité terrain pour que la caméra confirme que sa mesure est correcte.

Cependant, si le radar utilisé est de très faible résolution, cela pourrait en fait commencer à entrer en conflit avec ce que voit une caméra. Par exemple, disons, une famille d’oies traverse la route et la caméra peut le voir, mais le radar, qui n’est pas bon pour capter ces petits détails, ne le peut pas. Ce radar et cette caméra indiquent soudainement au système de navigation deux choses différentes : soit il y a quelque chose sur la route, soit il n’y en a pas, et cela va embrouiller le système.

Les radars que Tesla a supprimés étaient de très faible résolution. Ils offraient une résolution d’environ 10 ou 15 degrés à une portée d’environ 160 mètres. Ils étaient assez peu performants, comme le sont la plupart des radars traditionnels. En conséquence, le retrait de ce capteur radar par Tesla, à mon avis, ne fait pas une si grande différence, car ce qu’ils utilisaient fonctionnait si mal et rendait son système confus. Ils soutiennent également que leur appareil photo est si bon qu’il peut remplacer le lidar et tous les coûts et la complexité qui y sont associés.

Mais je pense que Tesla et d’autres utiliseront à l’avenir des capteurs radar plus performants pour permettre la conduite de niveau 3, 4 et 5, car, dans ces cas, vous avez besoin de redondances en place lorsqu’un système de caméra tombe en panne pour un raison ou autre. Les améliorations du radar que nous avons apportées à Oculii fournissent cette sauvegarde aussi précise qu’un système lidar, mais à un faible coût et avec très peu de changements nécessaires aux processus de fabrication actuels.

DN : À quel point cette technologie est-elle proche d’apparaître sur un véhicule de série ?

Steven Hong : En fait, nous venons d’annoncer notre tout premier partenariat de véhicules de production. Geely Motors, les propriétaires de Volvo et le plus grand constructeur automobile de Chine, vient de s’associer avec nous pour commencer à utiliser notre technologie de détection dans sa marque britannique de voitures de sport, Lotus. Les voitures utiliseront notre capteur EAGLE, le capteur radar d’imagerie 4D la plus haute résolution du marché, entre 2022 et 2023.